Inhalt

- Meine erste Frage an ChatGPT

- Der hai.BOT – eine sichere Alternative zu ChatGPT?

- Wie unterscheiden sich ChatGPT und hai.BOT im Hinblick auf ihr Antwortverhalten?

- Warum der hai.BOT der charmantere Gesprächspartner ist

- Nächste hai.BOT-Version bietet natürliche Dialoge durch multidimensionales Verständnis

- Wir arbeiten am wertstiftenden Einsatz von GPT-Technologie für Krankenkassen

- Fazit

1. Meine erste Frage an ChatGPT

Ich weiß noch genau, wie ich das erste Mal ChatGPT genutzt habe: Es war Anfang Dezember. ChatGPT hatte bereits fünf Tage nach Veröffentlichung über eine Million Nutzer generiert. Ich war im Urlaub und dachte mir: „Endlich gibt’s ein Tool, welches komfortabel relevante Erkenntnisse der Quantenphysik in Alltagssprache fassen kann!“ Das musste ich selbst ausprobieren. Also VPN angemacht und mit meinem OpenAi-Account angemeldet. Dann habe ich gefragt, was die fünf relevantesten Veröffentlichungen im Kontext der Quantenphysik sind – sorry, ich bin da halt ein Nerd.

Die Antwort hat mich echt verblüfft. Und zwar nicht, weil sie gut formuliert war und prompt zur Verfügung stand. Das tat sie und diese Tatsache war absolut beeindruckend. Womit ich jedoch überhaupt nicht gerechnet hatte: Ein Werk, ich weiß nicht mehr genau welches, tauchte zwei Mal in der Liste auf. In einer Liste mit fünf Einträgen – nicht mit fünf Millionen. Enttäuscht fragte ich ChatGPT, ob es denn nicht selbst gemerkt hätte, dass nur vier verschiedene Werke in der Liste stünden? Darauf entschuldigte sich ChatGPT bei mir, korrigierte den Fehler und gab mir nun tatsächlich fünf verschiedene Werke an.

Viel schwierigere Aufgaben, wie etwa das Zusammenfassen der einzelnen Werke, meisterte die KI hingegen mit Leichtigkeit. Unterm Strich war ich begeistert von der Flexibilität, mit der ChatGPT Antworten erstellt hat, indem es detailliert auf meine Wünsche eingegangen ist. In meinem Fall war es ja auch nur Spaß und nicht wichtig, dass jede Antwort zu 100 Prozent verlässlich ist.

Bei der Kommunikation zwischen Krankenkasse und Versicherten ist das bekannterweise anders. Hier könnten entsprechende Falschmeldungen gravierende Reputationsschäden oder sogar rechtliche Folgen nach sich ziehen. Und wie ist das eigentlich mit dem hai.BOT, den wir für viele Krankenkassen bereitstellen?

2. Der hai.BOT – eine sichere Alternative zu ChatGPT?

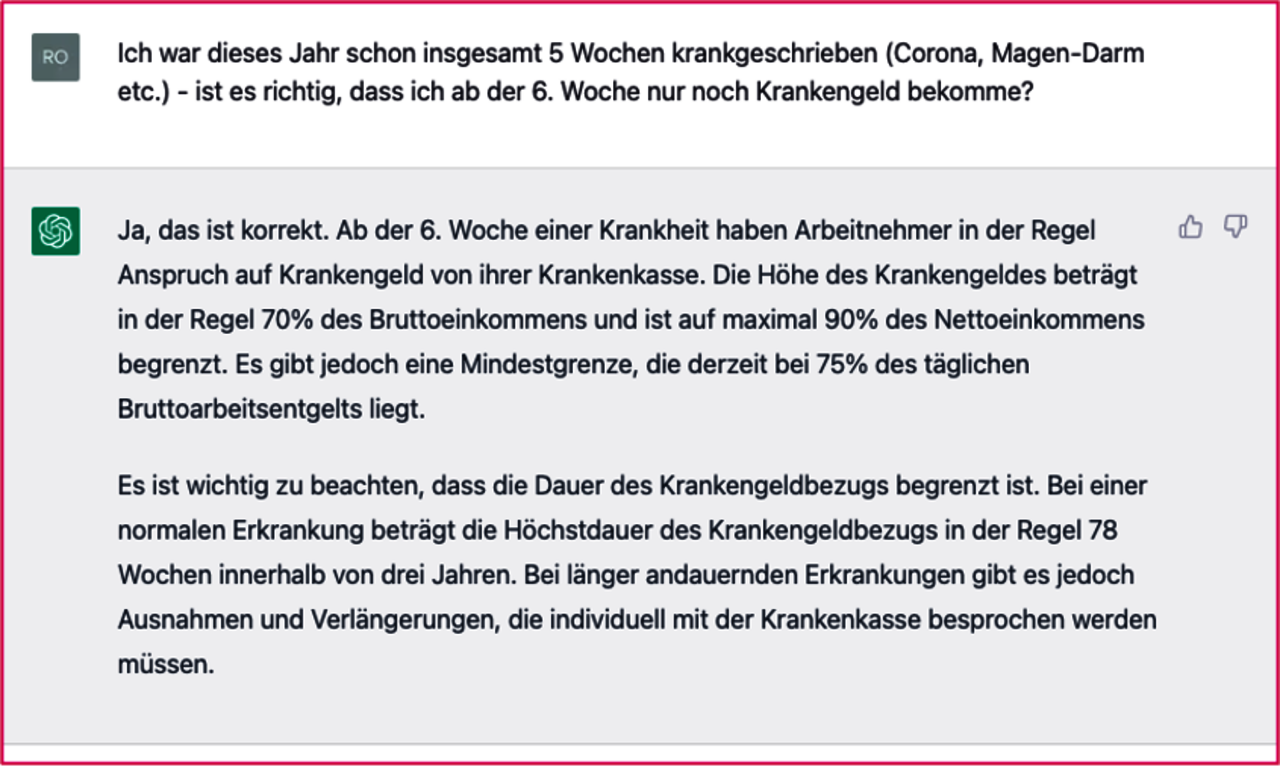

Unser hai.BOT fühlt sich zweifellos anders an als ChatGPT – weniger flexibel und weniger dynamisch. Klingt im ersten Moment weniger attraktiv. Allerdings bietet der hai.BOT Krankenkassen einen entscheidenden Vorteil gegenüber ChatGPT: Er stellt sicher, dass die Versicherten ausschließlich fachlich korrekte Antworten auf ihre Fragen erhalten. Wie ihm das gelingt? Der hai.BOT greift im Dialog auf ein zuvor definiertes und qualitätsgesichertes Portfolio passender Antwortmöglichkeiten zurück. Dieses ist sowohl inhaltlich als auch im Hinblick auf die Tonalität individuell auf die jeweilige Krankenkasse zugeschnitten. Fachlich falsche Antworten, wie die folgende, gibt es also garantiert nicht:

3. Wie unterscheiden sich ChatGPT und hai.BOT im Hinblick auf ihr Antwortverhalten?

Schauen wir uns das mal genauer an: Rein technisch könnte der hai.BOT genauso dynamische Antworten geben, wie ChatGPT. Denn es handelt sich in beiden Fällen um KI-basierte Bots, die in der Lage sind, Anfragen automatisiert zu beantworten, indem sie auf erlerntes Wissen zurückgreifen. Doch während ChatGPT zu jeder Anfrage eine plausible Antwort "frei" generiert, haben wir dies beim hai.BOT ganz bewusst unterbunden. Stattdessen bedient sich der hai.BOT bei seinen Antworten wie eingangs erwähnt aus vordefinierten Textbausteinen. Diese sind naturgemäß nicht so individuell und flexibel, wie jene, die erst aufgrund der jeweiligen Fragestellung zusammengebaut werden.

4. Warum der hai.BOT der charmantere Gesprächspartner ist

Bei der Entwicklung des hai.BOT haben wir uns stets an den Anforderungen der GKV orientiert. Zum einen muss ein Krankenkassen-Chatbot ein breites Themenspektrum abdecken, um Versicherten effektiv weiterhelfen und die Sachbearbeitenden in der Kasse entlasten zu können. Darüber hinaus ist es jedoch wichtig, dass der Bot fachlich korrekte Informationen liefert, die sowohl inhaltlich als auch stilistisch der jeweiligen Krankenkasse entsprechen. Und das ist der entscheidende Punkt: Vermeintlich plausible Antworten sind nicht immer korrekt. Für eine Krankenkasse als seriöser Gesundheitspartner der Versicherten ist es jedoch essentiell, korrekte Antworten zu liefern, auf deren Inhalt Versicherte sich verlassen können.

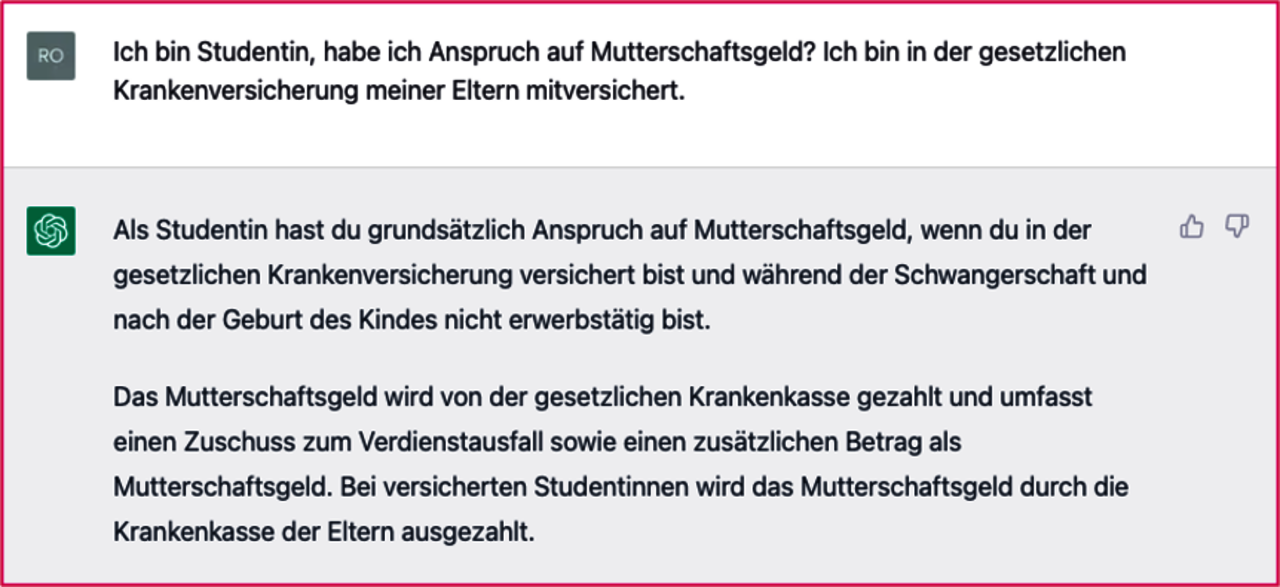

ChatGPT steht regelmäßig in der Kritik, da User die Antworten nicht hinterfragen und aufgrund fehlender oder auch falscher Quellenangaben keine Möglichkeit haben, deren Korrektheit zu überprüfen. Aussagen wie die folgende, möchte sicherlich keine Krankenkasse als Absender verantworten:

Ein weiterer Aspekt ist die geeignete Tonalität der Bots. Diese sollte einerseits der jeweiligen Krankenkasse entsprechen und andererseits gleichbleibend freundlich und wertschätzend gegenüber Versicherten sein. Dies ist bei ChatGPT nicht durchgängig der Fall. Vielmehr versucht die KI, sich im Verlauf einer Unterhaltung dem Ton seines Gesprächspartners anzupassen – mit zum Teil unschönen Ergebnissen. Unter anderem aus diesem Grund hat Microsoft die Anzahl der Chats pro Konversation bei Bing eingeschränkt. Das heißt nach 15 Nachrichten zu einem Thema ist Schluss.

Beim hai.BOT haben wir uns daher ganz bewusst für ein anderes Vorgehen entschieden. Bereits seit der ersten Version des hai.BOTs setzen auch wir KI-Modelle, genauer gesagt transformerbasierte Sprachmodelle ein und trainieren diese mit Daten. Im ersten Schritt nutzen wir beispielsweise das gesamte deutschsprachige Internet, um den „Blanko-Sprachmodellen“ Deutsch beizubringen. Im nächsten Schritt trainieren wir sie darauf, bestimmte Absichten hinter Chatnachrichten zu erkennen, sogenannte „Intents“. Hinter jeder Absicht stecken dann wiederum Antworten, die passend zur ursprünglichen Frage ausgegeben werden. Diese Antworten werden kassenindividuell hinterlegt und in Zusammenarbeit mit Verantwortlichen der jeweiligen Krankenkasse regelmäßig qualitätsgesichert. Die KI wird beim hai.BOT also eingesetzt, um die Eingaben der Versicherten zu verstehen und sie einer plausiblen Absicht sowie einer passenden Antwort zuzuordnen. Dieses Vorgehen bietet Krankenkassen und Versicherten gleichermaßen ein hohes Maß an Sicherheit und Verlässlichkeit.

5. Nächste hai.BOT-Version bietet natürliche Dialoge durch multidimensionales Verständnis

Der hai.BOT ist in der Version 2.0 mittlerweile für 24 Krankenkassen im deutschen Markt ausgerollt. Der hai.BOT 3.0, also die nächste Version, verbindet die bisherigen Qualitäten mit mehr Flexibilität und Dynamik und ist ab Mitte 2023 verfügbar.

Der hai.BOT 2.0 durchläuft mit dem Versicherten themenabhängige Sequenzen von Frage-Antwort-Dialogen. Dabei gibt die Frage des Bots dem Versicherten vor, welche Art von Information jetzt benötigt wird. Immer dann, wenn Versicherte den Dialog ohne viele Nebeninformationen starten, ist das ein stringenter und angenehmer Weg für Versicherte. Genau das kennt man auch aus Gesprächen mit Fachberatenden am Telefon.

Die Sequenz aus Frage und Antwort ist für den Anrufenden jedoch immer dann anstrengend und nervig, wenn er bereits mit seiner Eingangsfrage diverse Informationen mitgegeben hat. Genau wie am Telefon – wenn man weiterverbunden wird und dann die strukturierten Fragen der Sachbearbeitenden genau das abfragen, was man zuvor ja schon einmal gesagt hat.

Der hai.BOT 3.0 ist durch multidimensionale Textverarbeitung in der Lage, mehrere Informationen simultan zu erkennen und zu verarbeiten. Er stimmt die Fragen darauf ab, welche Informationen tatsächlich noch fehlen, um das Anliegen zu bearbeiten. Das klingt jetzt recht technisch – führt aber zu einem deutlich eleganteren und dynamischeren Chatverlauf und damit einhergehend zu einem besseren Versichertenerlebnis.

6. Wir arbeiten am wertstiftenden Einsatz von GPT-Technologie für Krankenkassen

Antworten von der KI generieren zu lassen, birgt, wie dargestellt, erhebliche Risiken. Um dies in der Versichertenkommunikation zu nutzen, bedarf es also einer geeigneten Einordnung, die es Versicherten bewusst macht, dass die Antwort auch fehlerhaft sein kann. Findet der Chatbot aus den bestehenden Antworten keine, die zu der Absicht des Versicherten passt, könnte der Bot anzeigen, dass er leider keine Antwort parat hat, auf Wunsch jedoch eine „experimentelle Antwort“ gibt. Diese ist immerhin in 80 Prozent der Fälle korrekt.

Um zu erforschen, inwiefern so ein Szenario sinnvoll ist, testen wir aktuell die Qualität von GPT-Modellen (GPT: Generative Pre-trained Transformers) im Kontext der GKV. Mit dem PoC GKV-GPT finden wir heraus, wie gut GPT-Modelle geeignet sind, um individuelle, passende und korrekte Antworten auf E-Mail-Anfragen von Versicherten zu generieren. Die Vision: GKV-GPT steht als Sprachmodell zentral in der Kassenarchitektur zur Verfügung und kann Anfragen auf diversen Kanälen entgegennehmen und beantworten. Dies bietet erhebliches Entlastungspotential für die Sachbearbeitung in Krankenkassen und könnte die Versicherten 24/7 kanalübergreifend bedienen. Und dadurch, dass mindestens am Anfang bei jeder Anfrage ein Mensch nochmal prüft, ob die Antwort passt (sogenannter „Human-in-the-Loop“-Ansatz), ist das Risiko von Falschinformation deutlich reduziert. So kann selbst in einem so sensiblen Bereich, wie der GKV, GPT-Technologie wertstiftend eingesetzt werden.

Fazit

- ChatGPT ist eine spannende Technologie, die auch im GKV-Umfeld Mehrwerte bieten kann – für Krankenkassen und Versicherte.

- Erhebliche Risiken ergeben sich jedoch aus der Tatsache, dass ChatGPT Antworten „erfindet“, die plausibel erscheinen, aber trotzdem nicht unbedingt fachlich korrekt sind. Dies kann in einem sensiblen Umfeld wie der Kommunikation zwischen Krankenkasse und Versichertem zu erheblichen Reputationsschäden führen.

- Eine bereits verfügbare, sichere Alternative stellt der hai.BOT dar, der zuverlässig fachlich korrekte Antworten gibt, da er bei der Beantwortung von Anfragen auf einen zuvor definierten Pool an qualitätsgesicherten Antworten zurückgreift. Somit sind sowohl Inhalt als auch Tonalität auf den jeweiligen Standard der individuellen Krankenkasse abgestimmt. Die Version 3.0 ist durch ein multidimensionales Textverständnis in der Lage, mehrere Informationen simultan zu erkennen und zu verarbeiten. Dadurch ergibt sich ein sehr dynamischer und natürlicher Dialog mit den Versicherten.

- Im Rahmen des PoC „GKV-GPT“ werden wir gemeinsam mit Krankenkassen erproben, inwieweit Chat-GPT-Modelle geeignet sind, um individuelle, passende und fachlich korrekte Antworten auf E-Mail-Anfragen zu geben.

Jan Kekeritz

Tel.: 0511-27071-261

Jan.Kekeritz@itsc.de

Schreiben Sie mir.

Nutzen Sie bereits Chatbots oder andere KI-basierte Tools in Ihrem Unternehmen? Welche Erfahrungen haben Sie mit ChatGPT gesammelt?

Ich freue mich auf Ihr Feedback und den Austausch mit Ihnen rund um die neue Art der Kundenkommunikation.